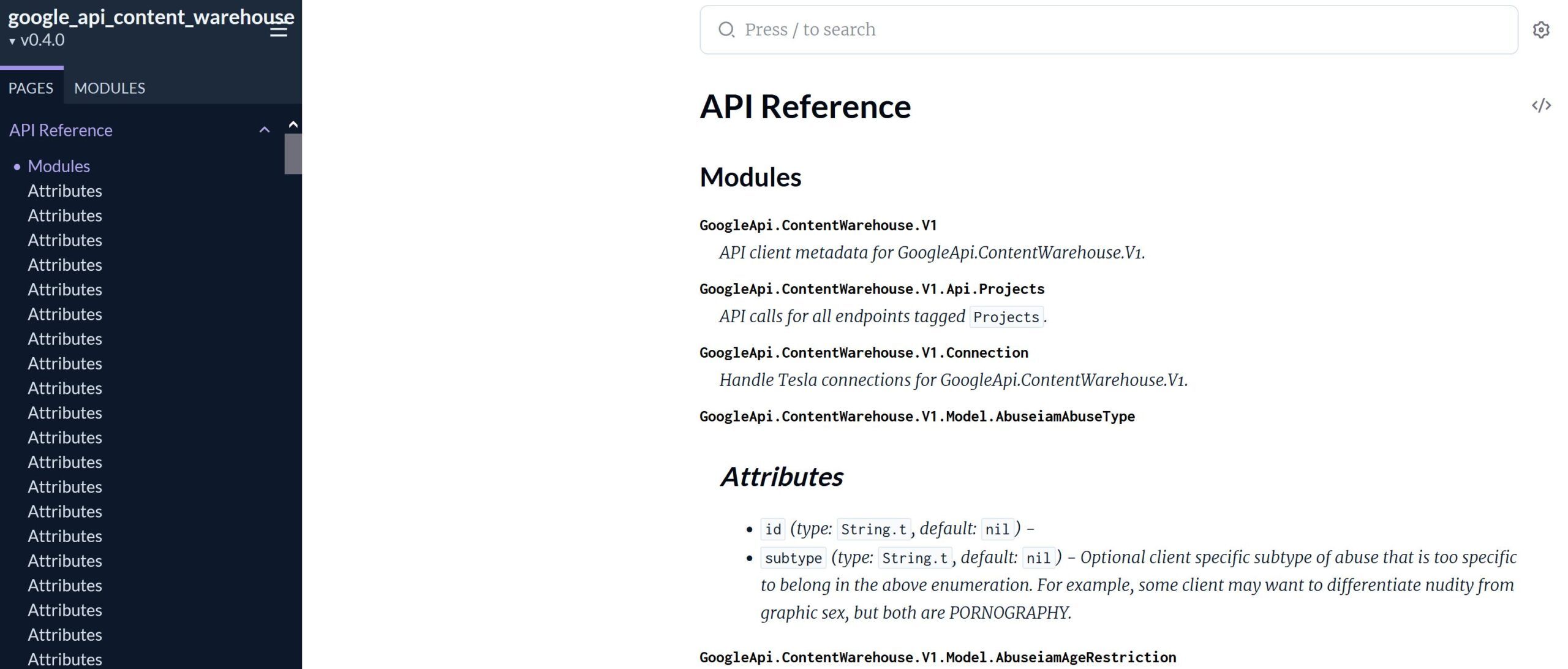

Der Google Leak 2024 ist eine Bezeichnung für die im März 2024 öffentlich gewordene Freigabe von rund 14 000 internen API-Referenzen aus Googles Content-Warehouse-Projekt, die versehentlich in einem GitHub-Repository landeten.

Das über mehr als 2 500 Seiten umfassende Dokumentenpaket, dessen Echtheit von ehemaligen Google-Mitarbeiter*innen bestätigt wurde, gewährt erstmals detaillierten Einblick in Googles Ranking-Signale und dient seither als zentrale Grundlage zahlreicher Analysen unter dem Schlagwort „Google Leaks 2024“.

Anlass, historischer Kontext und Umgang des Leaks

Der Anlass für die „Google Leaks 2024“ war eine versehentlich öffentlich gemachte Version der internen Content-Warehouse-API-Dokumentation: Ein Commit vom 27. März 2024 in einem GitHub-Repository der (inzwischen eingestellten) Document-AI-Warehouse-Bibliothek enthielt rund 2.500 Seiten mit 14.014 Attributen und blieb bis zum 7. Mai 2024 frei zugänglich.

Während dieses Zeitfensters gelangte der Datenbestand auch in den Index des externen Dokumentationsdienstes HexDocs, sodass er sich weiterverbreitete.

Als historische Initialzündung gilt die Entdeckung durch die SEO-Fachleute Erfan Azimi und Dan Petrovic, die das Material frühzeitig sicherten; Azimi leitete es am 5. Mai 2024 an Rand Fishkin weiter, woraufhin Fishkin (SparkToro) und nahezu zeitgleich Mike King (iPullRank) am 27. Mai die ersten ausführlichen Analysen veröffentlichten.

Bestätigung des Google Leak durch Google Mitarbeiter

Zur Authentifizierung legte Rand Fishkin die Dateien mehreren ehemaligen Google-Mitarbeitenden vor; zwei bestätigten unabhängig voneinander die typische interne Struktur und Namenskonvention der Dokumente.

Parallel untersuchte ein breites Netzwerk von Fachleuten das Leak in öffentlichen Repositories, rekonstruierte Commit-Historien und verglich die Attribute mit bekannten Google-Patenten sowie Aussagen aus dem DOJ-Kartellverfahren. Die kombinierte Analyse bildete die Grundlage für nachfolgende Community-Reviews, Konferenzbeiträge und Fachartikel.

Aufbau der Google-Suche laut Leak

Das geleakte Referenzpaket beschreibt 2.596 Module mit exakt 14.014 Feld- bzw. Attributdefinitionen. Die Module gruppieren sich in thematische Bereiche (u. a. Links, Inhalte, Nutzer-Signale, Qualitätsmetriken) und bilden das Datengerüst, auf das sämtliche nachgelagerten Ranking- und Serving-Systeme zugreifen.

Ranking-Pipeline

Crawling → Indexing → Retrieval → Vorfilter

Im ersten Verarbeitungsschritt durchsucht Trawler das Web; Scheduler steuert Frequenz und Priorität. Gefundene Ressourcen gelangen über Storeserver in das Index-Cluster Alexandria oder bei geringem Vertrauensniveau zunächst in eine Sandbox. Nach der Indexierung wählt Ascorer aus dem Word-Index bis zu 1.000 kandidatenDokumente aus, bevor Vorfilter wie WebMirror für Canonicalisierung und Duplikaterkennung sowie Passage-Extraktion tätig werden.

„Green Ring“ (1 000 DOCIDs) → „Blue Ring“ (Top 10)

Die von Ascorer erzeugte Liste der 1.000 bestbewerteten Dokumente wird intern als „Green Ring“ bezeichnet. Das Steuer- und Orchestrierungssystem Superroot reduziert diesen Kandidatenpool in Echtzeit auf die endgültigen zehn Ergebnisse – den „Blue Ring“ der SERP.

Twiddlers – nachgelagerte Relevanz- und Qualitätsfilter

Zwischen Green- und Blue-Ring greifen modulare Re-Ranking-Funktionen, die „Twiddlers“ genannt werden. Beispiele aus dem Leak sind NavBoost (Anpassung anhand von Klick-Logs) und FreshnessTwiddler (zeitliche Aktualität). Twiddlers verändern entweder den Information-Retrieval-Score oder verschieben Positionen direkt, bevor Superroot das finale Ergebnispaket an die Google-Webserver ausliefert.

Nutzersignale & NavBoost

NavBoost ist laut Leak ein zentrales Ranking-System, das 13 Monate historischer Klick- und Impression-Daten auswertet, um Ergebnisse nach tatsächlichem Nutzerverhalten dynamisch zu verstärken oder abzuwerten. Dabei werden mehrere Metriken getrennt gespeichert, darunter goodClicks, badClicks, lastLongestClicks (Langklicks) sowie „unsquashed“ vs. „squashed“ Klicks, die der Spam-Erkennung dienen

Klickstrecken (Click Chains)

Der Leak beschreibt, dass Google Klickfolgen innerhalb einer Sitzung verfolgt: wechselt ein Suchender nach einem unbefriedigenden Ergebnis sofort zu einem anderen, kann das Ziel-Dokument des zweiten Klicks einen Boost für die ursprüngliche Anfrage erhalten. Umgekehrt wirkt eine schnelle Rückkehr (Short-Click) als Negativsignal.

Long- vs. Short-Clicks

NavBoost bewertet die Verweildauer auf dem geklickten Ergebnis. Langklicks – wenn Nutzer lange beim Inhalt bleiben – gelten als Erfolgssignal, während rasche Rücksprünge Demotions auslösen können. Diese Messung erweitert klassische CTR-Modelle um qualitative Nutzungsdaten.

Query-Intent-Erkennung

Das System analysiert, ob eine Suche informations-, transaktions- oder navigationsorientiert ist. Überschreiten Klicks auf spezielle Vertikal-Features (z. B. Videos, Bilder) definierte Schwellen, aktiviert NavBoost für die betreffende Query dauerhafte Integrationen dieser Vertikalen in die SERP.

Geo-Fencing

Klick-Signale werden standort-spezifisch aggregiert: NavBoost unterscheidet Ergebnisse nach Land sowie Bundesstaat bzw. Provinz und trennt Desktop- von Mobile-Daten. Fehlen ausreichende Signale für eine Region, wird ein globales Modell auf die Query angewendet.

Durch die Kombination dieser Nutzersignale wirkt NavBoost als nachgelagerter Twiddler, der Positionen noch kurz vor Auslieferung der SERP feinjustiert und damit die klassische Link- und Inhaltsbewertung um Verhaltenstracking ergänzt.

Link-Signale

Der Google Leak zeigt sehr gut, wie wichtig Backlinks für gute Google-Ranking nachwievor sind

PageRank-Varianten

Die Leaks benennen mehrere parallel gepflegte PageRank-Messungen. rawPageRank entspricht der klassischen Berechnung über den gesamten Linkgraphen; PageRank_NS (“Nearest Seed”) gewichtet Links nach ihrer Distanz zu einem internen Satz vertrauenswürdiger Seed-Sites; firstCoverage PageRank erfasst den frühestmöglichen Link-Status unmittelbar nach dem ersten Crawl und dient als Startwert, bis eine reguläre Iteration vorliegt.

Anchor-Text & Kontext²

Neben dem eigentlichen Ankertext protokolliert das Feld context2 einen Hash der jeweils fünf Wörter links und rechts des Links; fullLeftContext und fullRightContext halten den gesamten Satzabschnitt vor. Auf diese Weise fließen semantische Hinweise aus dem unmittelbaren Umfeld eines Links direkt in die Bewertung ein und reduzieren die Wirkung überoptimierter, keyword-reicher Anker.

SourceType (Index-Tier)

Für jeden Anker wird der Index-Tier des Quelldokuments als sourceType gespeichert – grob in „High“, „Medium“ und „Low“ unterteilt. Links von hochfrequent aktualisierten “Base-Documents” innerhalb der Flash-Speicher-Schicht übertragen mehr Gewicht als Verweise aus tieferen Index-Ebenen.

Locality

Das Attribut locality misst, ob Quelle und Ziel sich in derselben geografischen „Bucket“ befinden; zusätzliche Felder wie localCountryCodes erlauben eine noch feinere Länder-Zuordnung. Interne Analysen deuten darauf hin, dass Links aus derselben nationalen Sphäre relevanter Queries einen verstärkenden Faktor erhalten.

ParallelLinks

Über parallelLinks zählt Google die Anzahl weiterer Links von derselben Quellseite zur gleichen Zieldomain. Jenseits einer definierten Schwelle wirken zusätzliche Verweise nur noch stark abgeschwächt, was eine Diversifizierung der Link-Quellen begünstigt.

In Summe zeichnen die Dokumente ein vielschichtiges Link-Bewertungssystem, das klassische Popularitätsmetriken (PageRank), semantische Nähe (Kontext²) und Qualitätssignale des Quelldokuments (SourceType, Locality, ParallelLinks) miteinander verknüpft.

| Die Leaks zeigen: Ja, Backlinks sind wichtig – sogar sehr

Links zählen weiterhin zu den wichtigsten Rankingsignalen, doch ihr Gewicht wird heute vielschichtig bestimmt: Spezial-PageRanks (etwa PageRank_NS), semantischer Anker-Kontext, Quellqualität (sourceType), Geobezug und Duplikatkontrollen (parallelLinks) wirken zusammen – wodurch nur thematisch passende, vertrauenswürdige Verweise einen nachhaltigen Boost liefern, während überoptimierte oder massenhaft wiederholte Links spürbar abgeschwächt werden. |

Content- und Entity-Signale

Google erfasst semantische Merkmale einer Seite nicht nur als pageEmbedding auf Dokument-, sondern über siteEmbedding auch auf Domänenebene. Beide Vektoren beschreiben die thematische Nähe zum Suchintent und fließen schon vor der eigentlichen Inhalt-Analyse in ein Focus-Score ein. Parallel dazu protokolliert die API einen KeywordStuffingScore (0 – 127), der überoptimierte Texte demotiviert und so Manipulationen vorbeugt.

Die Dokumentation listet außerdem explizite und implizite entities samt Häufigkeit und Relation, um Haupt- von Nebenthemen zu trennen.

Siteweite Qualitäts-Signale & Penalties

Auf Host-Ebene wird Qualität durch mehrere, teils historisch gewachsene Systeme bewertet. Der Leak bestätigt klassische Panda-Mechanismen für Thin- und Duplicate-Content, eine nachgeschärfte BabyPanda V2-Variante sowie ein generisches LowQuality-Flag. Ergänzend weist ein TrustedScore Domains mit konstant positiven Nutzersignalen aus – hoher Wert bedeutet weniger Risiko, durch Pandas Abwertungen getroffen zu werden.

Frische & Temporalität

Für Aktualität existieren spezifische FreshnessTwiddler-Felder, die das Index-Datum mit Byline-, syntactic- und semanticDate vergleichen und bei Diskrepanzen Twiddler-Anpassungen auslösen. Neu veröffentlichte Hosts durchlaufen zudem eine hostAge-Sandbox; das Attribut „hostAge → sandbox freshSpam“ begrenzt deren Sichtbarkeit, bis ausreichende Vertrauenssignale vorliegen.

Whitelists & sensible Suchthemen

Bei hochsensiblen Queries greift Google auf manuell oder halbautomatisch gepflegte Listen zurück. Attribute wie isElectionAuthority oder isCovidLocalAuthority heben verifizierte Quellen gezielt hervor, während andere Sites für dieselben Themen gebremst werden. Analog existiert ein Travel- und ein Health-Whitelist-Modul. Die Leak-Dokumente zeigen damit erstmals, dass Google in YMYL-Bereichen aktiv kuratiert.

Bedeutung von Marken & Popularität

Navigationsgetriebene Nachfrage als dominanter Ranking-Faktor

Wie bereits im Abschnitt “Nutzersignale & NavBoost” beschrieben, greift Google in der Schlussphase des Rankings auf das logs-basierte System NavBoost zurück. Die internen Unterlagen – und ergänzende Aussagen aus dem DOJ-Verfahren – charakterisieren NavBoost ausdrücklich als „eines der stärksten Ranking-Signale“ des gesamten Such-Stacks.

Zu den erfassten Kennzahlen gehören Impression-Zahlen, Short- und Long-Clicks sowie eindeutige Brand-Queries. Steigt das Volumen solcher Navigationssuchen („marke + login“, „marke + produkt“ u. Ä.), registriert NavBoost wiederkehrende GoodClicks und Verlängerungen der Aufenthaltszeit. Infolgedessen erhält die betreffende Host-Domain Positions-Aufwertungen, die sich – dank Query-Ausweitung innerhalb derselben Intent-Klasse – auch auf generische Suchanfragen ohne Markennamen übertragen können.

Implikationen für kleinere Domains ohne etabliertes Brand-Signal

Die starke Gewichtung brandgetriebener Nachfrage erzeugt einen strukturellen Vorteil für Websites, die bereits als Navigationsziel verankert sind. Domains ohne nennenswerte Marken-Sichtbarkeit weisen zwangsläufig weniger NavBoost-Signale auf und stoßen dadurch schneller an eine Ranking-Grenze. Die Leaks verweisen zugleich auf den Kennwert Host Normalized Site Rank (HostNSR), der das Verhältnis aus Klick-Engagement und Wettbewerbsumfeld skaliert und bei dauerhaft geringen Nutzer-Interaktionen ein Low-Quality-Flag auslösen kann.

Kleinere Anbieter müssen folglich zunächst externe Nachfragequellen – etwa Social- oder PR-Kanäle – aufbauen, um wiederkehrende Marken-Suchen zu generieren, oder sich thematisch so eng fokussieren, dass eine erkennbare Autoritätsnische entsteht. Ohne derartige Nachfrage-Indikatoren lassen sich die NavBoost- und HostNSR-Hürden nicht allein durch klassische On- und Off-Page-Optimierungen kompensieren.

Google Leaks 2024 Erkenntnisse: Muss man seine SEO-Strategie anpassen?

- Linkprofil & thematischer Kontext

Verweise behalten nur dann einen stabilen Effekt, wenn Ziel- und Quellinhalt semantisch eng beieinanderliegen und der Ursprung aus einer Domain mit hohem, konsistentem Vertrauens-Score stammt. Anchor-Texte sollten variiert werden; überoptimierte Schlüsselwörter im Anker oder eine Häufung identischer Linktexte auf Homepages riskieren Abschwächungen durch Penguin-artige Demotions. Relevante Begleitwörter im unmittelbaren Umfeld des Links erhöhen dagegen die thematische Passung – ein Signal, das im Leak als context2 geführt wird.

- Aufbau thematischer Cluster und interne Verlinkung

Die Kombination aus pageEmbedding, siteEmbedding und siteFocusScore legt nahe, dass Suchsysteme thematische Geschlossenheit auf Domain-Ebene honorieren. Ein klar strukturiertes Cluster aus Haupt- und Detailbeiträgen, verbunden über kontextsensitive interne Links, stärkt dieses Kohärenzsignal. Seiten mit abweichenden Themen oder schwacher inhaltlicher Tiefe sollten entweder ausgebaut oder aus zentralen Navigationspfaden entfernt werden, um den Fokusradius der Domain eng zu halten.

- Nutzerengagement fördern – Demand Creation außerhalb von Google

Die NavBoost-Logik gewichtet wiederkehrende, navigationsgetriebene Suchanfragen und Langklicks hoch. Marken- oder Domainsignale entstehen daher nicht nur durch klassische Suchmaschinenoptimierung, sondern vor allem durch externe Touchpoints, die eine direkte Suche nach dem Markennamen auslösen: Pressearbeit, Social-Media-Serien, Newsletter-Bindung oder Off-Page-Events. Ein wachsender Pool an Brand-Queries fungiert als nachhaltiger Verstärker für generische Rankings, weil er kontinuierlich positive Nutzersignale einspeist.

- Risikomanagement: Spam- und Penalty-Vermeidung

Mehrere Quality-Layer – Panda, BabyPanda V2, LowQuality-Flag – arbeiten stapelbar. Dünne Inhalte, Duplicate-Passagen oder aggressiv platzierte Keyword-Cluster können kumulative Abschwächungen auslösen, die sich site-weit ausbreiten. Regelmäßige Inhalts-Audits, ein rigider Umgang mit programmatischen Massenseiten und eine revisionssichere Versionierung umfangreicher Updates minimieren das Risiko. Gleiches gilt für Frischesignale: sinnvolle Aktualisierungen mit substanziellen Ergänzungen wirken positiv, während rein kosmetische Datumsänderungen vom FreshnessTwiddler erkannt und neutralisiert werden.

Zusammengefasst empfiehlt das Leak-Material eine Strategie, die qualitativ hochwertige Links in thematischer Nähe, klar fokussierte Inhaltscluster, nachweisbares Nutzungsinteresse an der Marke und konsequentes Qualitäts-Monitoring miteinander verbindet – traditionelle Einzeloptimierungen entfalten erst unter diesem holistischen Ansatz ihre volle Wirkung.

Kontroverse & Branchenreaktionen

Mehrere Stellen in den geleakten Unterlagen widersprechen früheren öffentlichen Aussagen von Google. So hieß es zum Beispiel, es gebe angeblich keinen „Website Authority Score“ und auch keine Nutzung von Chrome-Daten – beides taucht im Leak als gespeichertes Signal auf.

SEO-Experte Mike King spricht darum von einem Vertrauensproblem: Google habe Dinge abgestritten, die nun schwarz auf weiß belegt sind. Google bestätigt zwar die Echtheit der Dateien, betont aber, sie seien „aus dem Zusammenhang gerissen, unvollständig oder veraltet“ und eigneten sich nicht, um das heutige Ranking eins zu eins abzuleiten.

Das Portal Search Engine Land startete eine Artikelserie, in der der Leak Stück für Stück eingeordnet und Googles Einwände kritisch geprüft wurden. Bei SMX Advanced Europe 2024 widmete Mike King seine Eröffnungsrede den „Folgen des Content-Warehouse-Leaks“ und stellte fest, dass klassische Link- und Content-Signale ohne zusätzliche Nutzerdaten (NavBoost) an Wirkung verlieren. In weiteren Diskussionsrunden ging es um Qualitätsrichtlinien, den Umgang mit sensiblen Themen und den wachsenden Einfluss von KI-gestützten Re-Ranking-Systemen.

Binnen weniger Wochen kamen die meisten Fachleute zu einem gemeinsamen Fazit: Der Leak liefert keinen vollständigen „Masterplan“ der Google-Suche, zeigt aber klarer als jede Quelle zuvor, welche Signale tatsächlich zählen – und wie stark dies von Googles öffentlich verbreiteten Aussagen abweicht.

Fazit: Der Google Leak 2024 ist spannend, ABER…

Die geleakten Dokumente gewähren der SEO Welt zwar einen seltenen Blick hinter die Kulissen, doch sie verraten nichts über die Gewichtung einzelner Rankingfaktoren – dieses Kernwissen fehlt weiterhin der gesamten SEO Branche. Zudem handelt es sich nur um eine Momentaufnahme; etliche Module könnten inzwischen veraltet oder ersetzt sein. Und mit neuen KI-Features wie „AI Overviews“ stehen bereits nächste Suchsysteme bereit, die bestehende Signale verändern oder ganz neue hinzufügen dürften.

1. Was genau wurde geleakt?

Geleakt wurden interne Google-Dokumente, die hunderte angebliche Rankingfaktoren und Backend-Module beschreiben.

2. Stammt das Material wirklich von Google?

Die Dateien wirken authentisch, weil sie interne Bezeichner und typische Formatierungen enthalten. Google hat den Leak bislang jedoch weder bestätigt noch dementiert – absolute Gewissheit gibt es also nicht.

3. Sind die Inhalte aktuell?

Das bleibt unklar. Wahrscheinlich handelt es sich um eine Momentaufnahme; einzelne Module könnten inzwischen angepasst, neu gewichtet oder ganz gestrichen sein.

4. Fehlen wichtige Informationen?

Ja. Vor allem die konkreten Gewichtungen der Rankingfaktoren fehlen – ohne sie lässt sich die tatsächliche Relevanz jedes Signals nur vermuten.

5. Warum ist das trotzdem spannend für die SEO Welt?

Erstmals sieht die SEO Branche in groben Zügen, welche Signale Google überhaupt erfasst. Selbst ohne Gewichte verraten die Dokumente viel über technische Prioritäten.

6. Welche Risiken birgt eine Überinterpretation?

Wer jede Erwähnung im Leak blind als „Top-Faktor“ einstuft, könnte Ressourcen falsch investieren. Ohne Gewichtungen bleibt vieles Spekulation.

7. Was ist mit neuen KI-Features wie „AI Overviews“?

Die geleakten Unterlagen decken diese Innovationen noch nicht ab. Künftige KI-Schichten könnten bestehende Signale verschieben oder zusätzliche einführen.

8. Kann Google rechtlich gegen die Diskussion des Leaks vorgehen?

Über die Inhalte zu berichten oder sie zusammenzufassen gilt in der Regel als zulässig.

9. Welche praktischen To-dos ergeben sich für SEOs?

Erstens: Dokumente lesen, aber skeptisch bleiben. Zweitens: Eigene Tests durchführen, um reale Effekte zu messen. Drittens: Prozesse agil gestalten, falls Google Module ändert.

10. Wird es weitere Enthüllungen geben?

Möglich. Der aktuelle Leak wirft neue Forschungsfragen auf; je nach Reaktion von Google oder Whistleblowern könnten zusätzliche Dateien folgen.