Duplicate Content, zu Deutsch Doppelte Inhalte, bedeutet, dass identischer Content mehrfach auf verschiedenen URLs aufrufbar ist. Hierbei wird zwischen drei verschiedenen Arten unterschieden: nach interner, externer und near Duplicate Content.

- Interner Duplicate Content – Inhalte, die auf einer Website auf verschiedenen URLs vorhanden sind (z. B. wenn die Websites mit http:// und mit https:// einzeln aufrufbar ist).

- Externer Duplicate Content – Inhalte, die auf verschiedenen Websites aufrufbar sind. Diese Art ist häufig bei Shops zu finden, wenn diese Produktbeschreibungen 1:1 von Herstellern aus dem Internet kopieren.

- Near Duplicate Content – Inhalte, die einander sehr ähnlich sind (bspw. immer die gleichen Textbausteine, die mehrfach auf unterschiedlichen URLs verwendet werden oder auch Textbausteine, die nur ganz leicht umgeschrieben wurden).

Von Duplicate Content wird nicht gesprochen, wenn ein kurzer Vorspann und eine Überschrift von Beiträgen auf einer Übersichtsseite zum Anteasern verwendet werden. Wörtliche oder ähnliche Zitate, die nur gelegentlich in einem Text vorkommen, stellen ebenso keine Gefahr dar.

Weitere Beispiele für internen Duplicate Content:

➢ Die Website ist mit und ohne www. aufrufbar

➢ URL-Parameter und Sessions-IDs in den URLs

➢ Wiederkehrende, identische Produktbeschreibungen

➢ Paginierungen von Kategorieunterseiten (Seitennummerierungen)

➢ Identische Kategorie und Schlagwörter-Seiten (Übersichtsseiten)

➢ Meta Tags, wie ein identischer Title Tag, werden auf verschiedenen URLs gleichzeitig verwendet

Warum stellt Duplicate Content ein Problem dar und wie bewertet Google doppelte Inhalte?

Duplicate Content kann in der Regel zu keiner Abstrafung durch Google führen. Eine Ausnahme stellt der Einsatz von doppelten Inhalten dar, um mit Spam-Methoden (Black Hat SEO) eine Website künstlich in den Suchergebnissen nach vorne zu bekommen.

Solche Spam-Methoden, wie Scrapper Sites (geklaute Inhalte) und Spinning Content (automatisiert umgeschriebene Texte), werden manuell abgestraft bei Entdeckung.

Das größte Problem ist für Google das Verständnis, welche URL bei duplizierten Inhalten ranken soll. Gibt es auf verschiedenen URLs die gleichen oder sehr ähnlicher Content, ist es für den Google-Bot schwierig zu entscheiden, welche URL zu welchen Inhalten in den Suchergebnissen gefunden werden soll. Hier entscheidet Google in so einem Fall selbst, und das leider nicht immer richtig. Daher ist es wichtig, DC zu vermeiden und Google ganz klar zu zeigen, welche URL zu welchen Inhalten ranken soll.

Google will außerdem Websites im Index haben, die den Usern einen nennenswerten Mehrwert mit einzigartigem und qualitativ hochwertigem Content bieten. Bei kopierten Texten ist dies nicht der Fall.

Zudem will der Konzern die Crawler nicht unnötig häufig über eine Website schicken – Zeit und andere Ressourcen sollen gespart werden. Bei einer Website mit sehr vielen Duplicate Content kommt der Crawler unter Umständen nicht so häufig vorbei wie bei Websites, die frei von duplizierten oder ähnlichem Content sind. Dies kann sich negativ auf deine Rankings auswirken.

Ein gutes Video findest du hier zu diesem Thema von Google selbst:

Duplicate Content finden

Es gibt verschiedene Wege, die unterschiedlichen Arten von DC zu erkennen:

- Internen Duplicate Content analysieren

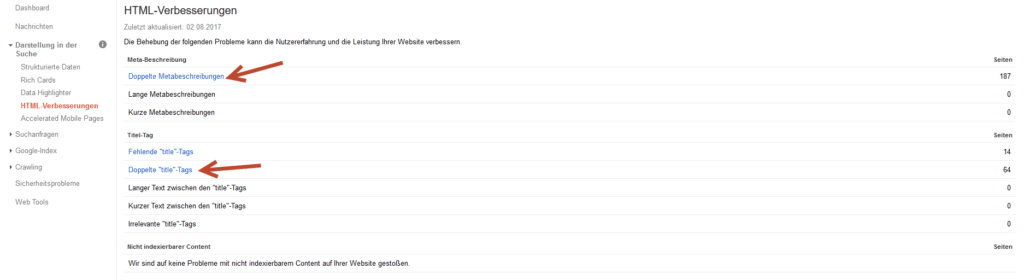

Mit der kostenlosen Search Console werden dir doppelte (duplicate) Elemente auf deiner Website angezeigt. Gehe dazu auf „Darstellung der Suche“ –> „HTML-Verbesserungen“, um die Fehler anzeigen zu lassen

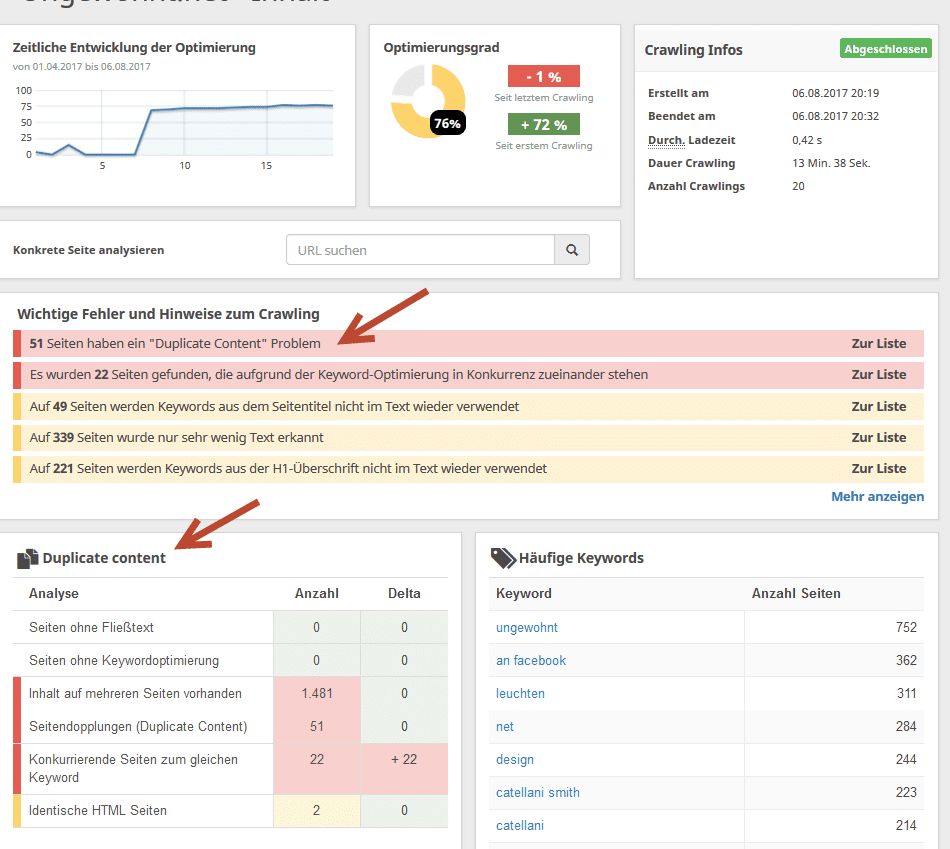

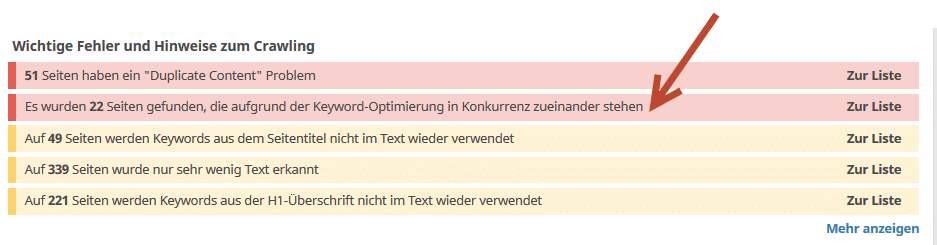

Mit kostenpflichtigen Analyse-Tools wie Seobility oder Ryte.com und vielen weiteren OnPage-Analyse-Tools kannst du dir Duplicate Content anzeigen lassen.

Auf Siteliner.com kannst du deine Website kostenfrei auf duplizierte Inhalte überprüfen lassen.

- Externen Duplicate Content analysieren

Über die Website Copyscape kannst du dir anzeigen lassen, ob es Kopien zu deiner URL/Website im Netz gibt. Das Analyse-Tool überprüft dabei das Web nach externen Quellen, die ähnliche oder identische Übereinstimmungen zu deiner Anfrage haben.

- Über die Google-Suche (externer wie auch interner DC)

Über die Suche von Google können sowohl interner wie auch externer Content gefunden werden. Gib dazu eine Textpassage ein, von der du denkst, dass diese doppelt auf deiner oder anderen Website vorhanden ist. Setze die Passage des Textes mit Anführungszeichen („“) in die Suche ein – bekommst du jetzt mehrfache Ergebnisse angezeigt, solltest du überprüfen, ob diese Ergebnisse identische Inhalte vorweisen.

- Near Duplicate analysieren

Mit den bereits genannten Tools wie Seobility lassen sich auch häufig Texte erkennen, die sehr ähnlich zueinander sind. Unter dem Punkt „Inhalt“ -> „Konkurrierende Seiten zum gleichen Keyword“ lassen sich oft Seiten finden, die near DC haben. Auch Siteliner.com zeigt dir URLs auf deiner Website an, die einander ähneln. Bei Seobility.net findest du über „Inhalt“ -> „Duplicate Content“ alle Seiten aufgelistet, die aufgrund der Keyword-Optimierung in Konkurrenz zueinanderstehen.

Lösungen von Duplicate Content, die funktionieren

Sollte bei der Analyse herauskommen, dass du DC-Probleme auf deiner Website hast, solltest du handeln und die Probleme beheben. Im Folgenden zeige ich einige Möglichkeiten auf, DC zu beheben.

✔ Weiterleitungen für die Domain und einzelne URLs

Eine Domain sollte entweder über www. oder ohne erreichbar sein: Nehmen wir an, dass deine Website nur über www. erreichbar sein soll, musst du einen entsprechenden Weiterleitungsbefehl in die .htaccess-Datei eintragen.

- Ferner sollte deine Website, falls du über dies verfügst, nur über https:// aufgerufen werden können.

- Verfügst du über alte URLs, die über identische Inhalte im Vergleich zu deiner neuen Website verfügen, solltest du diese entsprechend mit einer 301-Weiterleitung (Redirect) umleiten. Diesen Befehl trägst du ebenfalls in die .htaccess-Datei deiner Seite ein

- Auf dieser Website: http://www.htaccessredirect.de/ findest du zahlreiche Codes, wie du die .htaccess mit Weiterleitungen konfigurieren kannst.

✔ Seiten auf „noindex“ setzen

Über den Eintrag eines Meta-Tags mit „noindex,follow“ gibst du Google die Anweisung, die Website nicht in den Suchergebnissen mit aufzunehmen. Damit kannst du doppelte Inhalte schnell beheben. Bedenke allerdings, dass diese Seiten immer wieder von Google überprüft werden und damit Crawler-Budget verbrauchen. Wenn eine Seite nicht mehr benötigt wird, solltest du überlegen, ob es nicht Sinnvoll wäre, diese zu löschen und/oder mittels 301 redirect umzuleiten.

✔ Canocial Tags

Mithilfe des Canonical Tags kannst du anzeigen, welche URL das Original ist und welche Kopie von Google ignoriert werden soll. Wie genau kanonische URLs verwendet werden können, findest du auf https://support.google.com/webmasters/answer/139066?hl=de&ref_topic=4617741.

✔ Mehrsprachige Websites

Häufig kann es zu Problemen mit Duplicate Content auf mehrsprachigen Websites kommen. Wie du die Sprachversion definieren kannst, um Fehler zu vermeiden, findest du hier.

✔ Kopierte Inhalte entfernen oder komplett neu- / umschreiben

Geklaute Produktbeschreibungen und doppelt verwendete Texte sollten von einer Website schnell verschwinden. Google will einzigartige Texte auf deiner Website sehen und sieht kopierte Inhalte nicht gerade als Zeichen von hoher Qualität an.

Lösungen für Duplicate Content, die nicht empfohlen werden

⚡ Das Ausschließen des Google-Crawlers über die robots.txt-Datei, um DC zu beheben, wird nicht empfohlen, da das Ausschließen nicht zwangsweise dazu führt, dass die URL aus dem Index von Google entfernt wird. So bleibt der Duplicate Content bestehen, nur kann Google diesen nicht wieder erneut crawlen.

⚡ Der Punkt in der Search Console „URLs entfernen“ sollte ebenfalls nicht angewendet werden, um doppelte Inhalte zu entfernen, da hier nur für kurze Zeit URLs aus dem Index ausgeschlossen werden und nach kurzer Zeit wahrscheinlich von Google wieder aufgenommen werden.

Tipps von Google zur Vermeidung

Auf https://support.google.com/webmasters/answer/66359?hl=de gibt es viele Tipps von Google selbst zur Vermeidung und Behebung:

- 301-Weiterleitungen verwenden

- Immer die gleichen URL-Strukturen verwenden

- Die Search Console nutzen, um sich bspw. auf bestimmte Sprachversionen festzulegen

- Wiederkehrende Textbausteine vermeiden

- Ähnlichen Content und kopierte Inhalte nicht veröffentlichen oder auf noindex setzen

Zusammenfassung

Einzigartige Text auf einer Website sind für Google ein Zeichen von hoher Qualität und bieten dem Leser einen Mehrwert. Setze daher alles daran, DC-Probleme zu finden und zu beheben. Mit diversen SEO-Tools kannst du die Übeltäter schnell finden und entsprechend reagieren. Lösche entweder Duplicate Content oder setze doppelte Inhalte auf „noindex,follow“.

Sollte eine andere Website dein Content 1:1 kopieren, solltest du den Webmaster kontaktieren und darauf hinweisen und zur Not sogar mit rechtlichen Schritten drohen. Die eigenen Inhalte auf deiner Website sind dein höchstes Gut und sollten dementsprechend gepflegt werden.

Durchschnittliche Bewertung: 4.8 / 5. | Anzahl der Bewertungen: 8